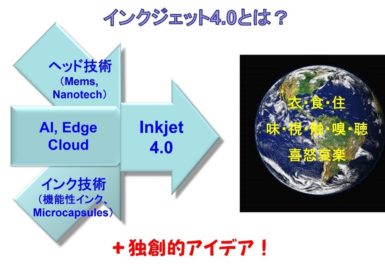

AI(人工知能)は、コンピュータシステムが人間のような知的なタスクを実行する能力を指します。AIは機械学習、深層学習、自然言語処理などの技術を組み合わせて実現されます。

AI(人工知能)は、コンピュータシステムが人間のような知的なタスクを実行する能力を指します。AIは機械学習、深層学習、自然言語処理などの技術を組み合わせて実現されます。

機械学習は、データを解析してパターンや規則を学習し、その結果を元に予測や判断を行う手法です。機械学習は大量のデータを活用することでモデルを訓練し、新たなデータに対して高い精度で応用することができます。

深層学習は、脳の神経細胞の仕組みを模倣した人工ニューラルネットワークを用いて機械学習を行う手法です。多層のニューラルネットワークを使用することで、複雑なパターンや特徴を学習できます。深層学習は画像認識や音声認識などの分野で非常に高い性能を発揮しています。

自然言語処理は、人間の自然言語(英語や日本語など)をコンピュータが理解し、処理するための技術です。テキストデータの解析や翻訳、質問応答システムの構築などに応用されます。自然言語処理は言語の文脈や意味を理解するための複雑なアルゴリズムを利用します。

AIの応用は非常に広範であり、医療診断、金融取引の予測、交通制御、自動運転などの領域で活用されています。AIは時間の経過とともに進化し、ますます高度なタスクを遂行する能力を獲得しています。

しかしながら、AIにはいくつかの課題も存在します。倫理的な問題やプライバシーの懸念、アルゴリズムのバイアスなどがあります。人間の価値観や倫理規範に基づいてAIの開発と利用を進める必要があります。

AIの進歩は革新的であり、私たちの生活や社会に大きな影響を与えています。AIの利点を最大限に活用しつつ、倫理的な観点や社会的な影響を考慮しながら、持続可能で公正なAIの発展を追求していくことが重要です。

1.Artificial Intelligence(人工知能)

人工知能(Artificial Intelligence、AI)は、コンピュータシステムが人間のような知的なタスクを実行する能力を指します。AIは、機械学習、深層学習、自然言語処理、コンピュータビジョンなどの技術を組み合わせて実現されます。

AIの主な目標は、認識、理解、学習、推論、問題解決などの人間の知的な活動をコンピュータによって実現することです。これにより、AIは大量のデータを高速に処理し、パターンや規則を抽出し、予測や意思決定を行うことができます。

機械学習は、AIの中核技術の一つです。機械学習は、データからパターンや統計的な関係を学習し、その知識をもとに新しいデータに対して予測や分類を行います。機械学習は教師あり学習(ラベル付きデータから学習)、教師なし学習(ラベルのないデータからパターンを抽出)、強化学習(報酬信号に基づいて行動を学習)などの手法を用いて実現されます。

深層学習は、AIの一部として広く使われる手法です。深層学習は、多層の人工ニューラルネットワークを使用してデータを学習し、高度な認識や分類を行います。この技術は画像認識、音声認識、自然言語処理などの分野で優れた成果を上げています。

自然言語処理は、AIが人間の言語を理解し、生成・解析・翻訳などの処理を行う技術です。自然言語処理は、文章の構造や文脈、意味を理解するためのアルゴリズムやモデルを使用します。これにより、テキストマイニング、質問応答システム、機械翻訳などの応用が可能になります。

コンピュータビジョンは、AIが画像やビデオを解析し、物体認識、画像分類、動作認識などを行う技術です。コンピュータビジョンは、画像やビデオデータから特徴を抽出し、それに基づいて情報を把握するための手法やモデルを用います。

AIの応用は多岐にわたります。医療診断や治療計画の支援、金融取引の予測やリスク管理、交通制御や自動運転、ロボット工学、音声アシスタントなど、さまざまな領域で活用されています。

ただし、AIにはいくつかの課題も存在します。倫理的な問題やプライバシーの懸念、アルゴリズムのバイアスなどがあります。また、AIの導入による労働市場の変化や社会的な影響も考慮される必要があります。

AIの発展には、データの品質と量、アルゴリズムの開発、コンピュータの処理能力の向上などが重要な要素です。持続可能で公正なAIの発展を追求しながら、人間との共存や社会的な課題の解決に向けて研究と開発が進められています。

2.ML – Machine Learning(機械学習)

機械学習(Machine Learning、ML)は、コンピュータがデータから自動的に学習し、パターンや規則を抽出し、予測や判断を行うための手法です。人間が明示的にプログラムするのではなく、データと経験から学習して問題を解決する能力をコンピュータに与えることが特徴です。

機械学習は、大量のデータを解析し、その中からパターンや統計的な関係を見つけ出します。このプロセスでは、アルゴリズムやモデルを使用してデータの特徴を抽出し、学習と予測を行います。

機械学習には主に以下の3つのタイプがあります。

- 教師あり学習(Supervised Learning): 教師あり学習では、学習データにラベル(正解)が付与されています。コンピュータは入力データとそれに対応するラベルの関係を学習し、新しいデータに対して予測や分類を行います。例えば、メールの分類(スパム/非スパム)や画像認識などがあります。

- 教師なし学習(Unsupervised Learning): 教師なし学習では、学習データにラベルが付与されていません。コンピュータはデータの構造やパターンを自ら発見し、データをクラスタリングや次元削減などの手法で解析します。例えば、顧客セグメンテーションや推奨システムなどがあります。

- 強化学習(Reinforcement Learning): 強化学習では、エージェントが環境と相互作用しながら学習を行います。エージェントは試行錯誤を通じて報酬を最大化するための行動を選択し、環境の反応と報酬に基づいて学習します。例えば、ゲームのAIやロボットの制御などがあります。

機械学習は多くの応用領域で利用されています。画像認識、音声認識、自然言語処理、金融予測、医療診断、推薦システム、自動運転などがその一部です。データの量と品質、適切なアルゴリズムの選択、モデルのトレーニングと評価の重要性などが、機械学習の成功に影響を与えます。

しかし、機械学習にはいくつかの課題もあります。過学習(Overfitting)やデータのバイアス、説明性の欠如などが挙げられます。また、倫理的な問題やプライバシーの懸念も考慮される必要があります。

機械学習は継続的な研究と開発が行われており、AI技術の中核を担っています。ディープラーニング(深層学習)などの新しい手法やアルゴリズムの進歩により、機械学習の応用範囲と能力はますます拡大しています。

3.NLP – Natural Language Processing(自然言語処理)

自然言語処理(Natural Language Processing、NLP)は、コンピュータが人間の自然言語(英語や日本語など)を理解し、生成・解析・翻訳などの処理を行うための技術です。NLPは、人間の言語とコンピュータとの間のインタラクションを可能にするために開発されました。

NLPは、言語の文法や意味、文脈を理解するための様々な技術や手法を使用します。以下にNLPの主要な要素をいくつか紹介します。

- 自然言語理解(Natural Language Understanding、NLU): NLUは、テキストデータや音声データから情報を抽出し、意味や文脈を理解するための技術です。NLUは、形態素解析(単語の分割)、構文解析(文法的な構造の解析)、意味解析(文の意味や意図の解析)、固有表現抽出(人名や場所の識別)、意味役割付与(文中の要素の役割の特定)などを含みます。

- 自然言語生成(Natural Language Generation、NLG): NLGは、コンピュータが自然言語で文章を生成するための技術です。NLGは、テンプレートベースの文章生成から、より高度な手法である言語モデルを使用した文章生成まで、さまざまなアプローチがあります。

- 機械翻訳(Machine Translation、MT): MTは、一つの言語から別の言語への自動翻訳を行う技術です。機械翻訳は、統計的手法やニューラルネットワークベースの手法など、さまざまなアプローチで実現されています。

- 質問応答(Question Answering、QA): QAは、与えられた質問に対して自動的に適切な回答を生成する技術です。QAシステムは、テキストデータやデータベースを検索し、情報を抽出して質問に対する回答を生成します。

NLPは、テキストデータの解析、情報抽出、意味理解、機械翻訳、会話エージェント、情報検索などの応用に広く利用されています。また、音声認識との組み合わせにより、音声アシスタントや自動音声応答システムなどの開発も進んでいます。

NLPの課題には、文脈や意味の曖昧さ、多言語処理、文化や地域の言語のバリエーションなどがあります。しかし、機械学習とディープラーニングの進歩により、NLPの性能と応用範囲は飛躍的に向上しています。

4.DL – Deep Learning(深層学習)

深層学習(Deep Learning、DL)は、人工ニューラルネットワーク(Artificial Neural Networks)を用いて複雑なパターンや特徴を抽出し、高度なタスクを自動的に学習する機械学習の一分野です。DLは、多層のニューラルネットワークを構築し、それらの層でデータの表現を階層的に学習することで、高い性能を発揮します。

DLの主要な要素は以下の通りです。

- ニューラルネットワーク(Neural Networks): ニューラルネットワークは、神経細胞の働きを模倣した数学モデルです。ニューラルネットワークは、複数の層(隠れ層)で構成され、それぞれの層は複数のニューロン(ユニット)から構成されます。層と層の間には重みとバイアスと呼ばれるパラメータが存在し、これらのパラメータが学習によって調整されます。

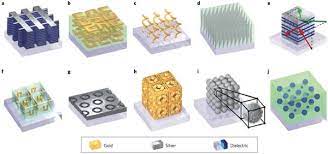

- ディープラーニングモデル(Deep Learning Models): ディープラーニングでは、多層のニューラルネットワークを使用します。一般的なモデルには、畳み込みニューラルネットワーク(Convolutional Neural Networks、CNN)や再帰型ニューラルネットワーク(Recurrent Neural Networks、RNN)、深層信頼ネットワーク(Deep Belief Networks、DBN)などがあります。これらのモデルは、特定のタスクやデータの特性に適したアーキテクチャを持っています。

- 訓練と学習(Training and Learning): DLモデルの学習は、大量のデータセットを使用して行われます。学習プロセスでは、モデルのパラメータ(重みとバイアス)を最適化するために、誤差逆伝播法(Backpropagation)と呼ばれるアルゴリズムが使用されます。誤差逆伝播法では、出力と正解データとの誤差を計算し、それを逆方向に伝播させて各層のパラメータを更新します。これにより、モデルはデータから特徴を抽出し、予測や分類を行う能力を獲得します。

- 特徴表現の自動学習(Automatic Feature Learning): DLの大きな特徴は、特徴表現の自動学習です。従来の機械学習手法では、人間が特徴を手動で設計する必要がありましたが、DLではモデル自体がデータから特徴を学習します。これにより、より抽象的で高度な特徴表現が獲得され、タスクのパフォーマンスが向上します。

DLは、画像認識、音声認識、自然言語処理、推薦システム、自動運転など、さまざまな領域で優れた成果を上げています。しかし、大量のデータと計算リソースが必要であり、モデルの設計や適切なハイパーパラメータの選択も重要です。また、過学習や解釈性の欠如などの課題も存在しますが、DLは現在のAI技術の中核を担っており、その発展は継続しています。

5.CNN – Convolutional Neural Network(畳み込みニューラルネットワーク)

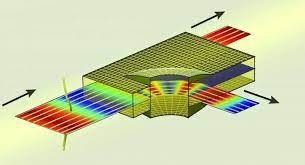

畳み込みニューラルネットワーク(Convolutional Neural Network、CNN)は、画像認識や画像処理のタスクに特化したディープラーニングの一種です。CNNは、画像の特徴を抽出するために畳み込み層とプーリング層から構成される特殊なアーキテクチャを持っています。

CNNの主な要素として以下の要素があります。

- 畳み込み層(Convolutional Layer): 畳み込み層は、画像の特徴を抽出するために使用されます。畳み込み層では、画像とフィルタ(カーネル)の畳み込み演算が行われます。フィルタは、小さなウィンドウの形で定義され、画像全体をスライドさせながら畳み込み演算が適用されます。この演算により、画像内の局所的な特徴が抽出されます。畳み込み層には、複数のフィルタが存在し、それぞれが異なる特徴を抽出します。

- プーリング層(Pooling Layer): プーリング層は、畳み込み層から得られた特徴マップを縮小するために使用されます。一般的には、最大プーリングや平均プーリングが使用されます。プーリング操作により、特徴マップのサイズが縮小され、計算量が削減されます。また、特徴の位置の微小な変化に対しても不変性を獲得することができます。

- 全結合層(Fully Connected Layer): 全結合層は、畳み込み層とプーリング層で得られた特徴を受け取り、最終的な分類や予測を行います。全結合層では、特徴マップをベクトル化し、それを入力として受け取る複数のニューロンが存在します。これらのニューロンは、学習によって重みとバイアスが調整され、最終的な出力を生成します。

CNNは、画像認識や物体検出、セグメンテーションなどのタスクに非常に効果的です。畳み込み層とプーリング層による階層的な特徴抽出により、画像内の局所的なパターンやテクスチャを学習し、より高いレベルの特徴を取得することが可能です。また、転移学習などの手法を用いることで、小規模なデータセットでも優れた性能を発揮することができます。

6.RNN – Recurrent Neural Network(再帰型ニューラルネットワーク)

再帰型ニューラルネットワーク(Recurrent Neural Network、RNN)は、ディープラーニングの一種であり、時系列データやシーケンスデータのモデリングに特化したネットワークです。RNNは、過去の情報を保持しながら現在の入力に対する処理を行うことができます。

RNNの主な特徴は、隠れ状態(Hidden State)と再帰的な結合を持つユニットです。RNNの各ステップでは、入力データと前のステップの隠れ状態を入力として、隠れ状態を計算します。この隠れ状態は、過去の情報を表現するメモリとして機能し、次のステップに渡されます。

RNNの主な要素として以下の要素があります。

- RNNユニット(RNN Unit): RNNユニットは、再帰的な結合を持つニューラルネットワークの基本的な要素です。RNNユニットは、入力データと前のステップの隠れ状態を入力として、次の隠れ状態を計算します。一般的には、シグモイド関数やハイパボリックタンジェント関数が使用されます。RNNユニットは、過去の情報を保持し、現在の入力に基づいて新しい情報を生成することができます。

- 隠れ状態(Hidden State): 隠れ状態は、RNNのメモリとして機能し、過去の情報を保持します。RNNの各ステップで更新され、次のステップに渡されます。隠れ状態は、ネットワークが過去の情報に基づいて現在の入力を処理するために重要な役割を果たします。

- バックプロパゲーションスルー時間(Backpropagation Through Time、BPTT): RNNの学習は、バックプロパゲーションスルー時間と呼ばれる手法を使用して行われます。BPTTでは、RNNを時間方向に展開し、各ステップでの誤差を逆方向に伝播させることで、パラメータの更新を行います。このようにして、RNNは時系列データやシーケンスデータのパターンを学習することが可能です。

RNNは、機械翻訳、音声認識、テキスト生成、感情分析などのタスクに効果的です。RNNはシーケンスデータの長期的な依存関係をモデル化する能力を持ち、文脈や時間の情報を考慮することができます。しかし、長いシーケンスに対しては勾配消失や勾配爆発の問題が生じる場合があり、これらの課題に対処するために改良されたモデル(例:LSTMやGRU)が提案されています。

7.LSTM – Long Short-Term Memory(長短期記憶)

長短期記憶(Long Short-Term Memory、LSTM)は、再帰型ニューラルネットワーク(RNN)の一種であり、特に時系列データやシーケンスデータのモデリングにおいて、長期的な依存関係を捉える能力を持つ強力なネットワークです。

LSTMは、RNNの欠点である勾配消失問題を解決するために提案されました。勾配消失問題とは、RNNが長いシーケンスデータに対して勾配を逆伝播させる際に、勾配が指数的に減衰してしまい、遠い過去の情報を正確に学習することが困難になる現象です。

LSTMの主な要素として以下の要素があります。

- セル状態(Cell State): LSTMは、セル状態と呼ばれるメモリユニットを持ちます。セル状態は、長期的な情報を保持するために設計されており、時間の経過とともに情報を追加、削除、更新することができます。セル状態は、隠れ状態とは別に存在し、情報の流れを制御するゲートの役割を果たします。

- 忘却ゲート(Forget Gate): LSTMは、忘却ゲートと呼ばれるゲートを持ちます。忘却ゲートは、セル状態から不要な情報を削除するために使用されます。過去の情報を保持するかどうかを制御するため、忘却ゲートは0から1までの値を持ち、0に近い場合は情報を忘れ、1に近い場合は情報を保持します。

- 入力ゲート(Input Gate): 入力ゲートは、新しい情報をセル状態に追加するために使用されます。入力ゲートは、現在の入力と前の隠れ状態を考慮して、新しい情報を決定します。入力ゲートは0から1までの値を持ち、0に近い場合は情報を無視し、1に近い場合は情報を重要視します。

- 出力ゲート(Output Gate): 出力ゲートは、セル状態から隠れ状態を生成するために使用されます。出力ゲートは、セル状態の一部を選択して隠れ状態として出力します。出力ゲートは、隠れ状態が次のステップにどれだけ影響を与えるかを制御します。

LSTMは、シーケンスデータの長期的な依存関係をモデル化する能力を持っているため、音声認識、機械翻訳、文章生成などのタスクに広く使用されています。勾配消失問題を緩和し、長期的な情報の保持や重要な情報の取捨選択を可能にすることで、より高いモデルの表現力と性能を実現しています。

8.GAN – Generative Adversarial Network(敵対的生成ネットワーク)

敵対的生成ネットワーク(Generative Adversarial Network、GAN)は、生成モデルの一種であり、リアルなデータの生成や変換を行うために使用される強力なアルゴリズムです。GANは、2つの主要なコンポーネントである生成器と識別器の2つのネットワークから構成されています。

GANの主な要素として以下の要素があります。

- 生成器(Generator): 生成器は、ランダムノイズからデータを生成する役割を持つネットワークです。生成器は、入力としてランダムベクトル(潜在ベクトル)を受け取り、それを使ってデータのサンプルを生成します。生成器は初期段階ではランダムなノイズしか出力せず、訓練を通じてデータに近いサンプルを生成するように学習します。

- 識別器(Discriminator): 識別器は、生成器が生成したデータと実際のデータを区別する役割を持つネットワークです。識別器は、生成器からの生成サンプルと実際のデータを受け取り、それぞれがどちらであるかを判別します。識別器は、生成器がよりリアルなデータを生成するように学習する一方、実際のデータとの違いを見分ける能力も磨かれます。

GANは、生成器と識別器の2つのネットワークが対立的な関係にあります。生成器はリアルなデータを生成する能力を向上させるために努力し、識別器は生成器の出力と実際のデータを区別する能力を向上させるために努力します。両者は相互に学習し合いながら、より高品質な生成データを実現するために競い合います。

GANは、画像生成、音声合成、文章生成などのタスクにおいて優れた結果を示しています。GANを使用することで、リアルな画像やデータの生成が可能となります。また、データの変換やスタイルの変換にも応用でき、例えば写真を絵画のスタイルに変換するなどの表現力豊かな処理も可能です。GANは、創造的なデータ生成やデータ処理の分野において革新的なアプローチとなっています。

9.RL – Reinforcement Learning(強化学習)

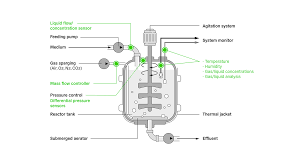

強化学習(Reinforcement Learning、RL)は、機械学習の一分野であり、エージェント(Agent)が環境と相互作用しながら、試行錯誤を通じて最適な行動を学習する手法です。RLは、報酬(Reward)という目標に基づいて行動を選択し、経験を通じて学習を進めることで最適な行動方策を見つけ出します。

RLの主な要素として以下の要素があります。

- エージェント(Agent): エージェントは、行動を選択する主体です。エージェントは環境と相互作用し、報酬を最大化するための最適な行動を学習します。エージェントは状態を観測し、その状態に応じて行動を選択します。

- 環境(Environment): 環境はエージェントが相互作用する対象です。環境はエージェントに状態を提供し、エージェントの行動に対してフィードバックとして報酬を与えます。エージェントの行動は環境に影響を与え、次の状態に移行します。

- 状態(State): 状態はエージェントが観測する環境の情報です。状態はエージェントの行動選択に影響を与えます。エージェントは現在の状態を観測し、それに基づいて最適な行動を選択します。

- 行動(Action): 行動はエージェントが環境に対して行う操作です。エージェントは状態を観測し、その状態に応じて最適な行動を選択します。行動の選択はエージェントの方策(Policy)に基づいて行われます。

- 報酬(Reward): 報酬はエージェントの行動の評価指標です。環境はエージェントに対して報酬を与え、エージェントは報酬を最大化するように行動を選択することを目指します。報酬は目標に対する良し悪しを示す数値であり、エージェントは報酬を最大化する方向に学習を進めます。

RLの目的は、エージェントが最適な行動方策を見つけ出すことです。エージェントは試行錯誤を通じて行動を選択し、報酬のフィードバックを受けながら学習を進めます。RLの手法には、価値ベースの手法(価値関数を用いる)、方策ベースの手法(方策関数を用いる)、およびその組み合わせを用いる手法などがあります。

強化学習は、ゲームAI、ロボット制御、自動運転などの領域で広く応用されています。エージェントが環境との相互作用を通じて学習し、最適な行動を獲得する能力を持つため、複雑な問題に対しても柔軟かつ効果的な解決策を提供することができます。

10.CV – Computer Vision(コンピュータビジョン)

コンピュータビジョン(Computer Vision、CV)は、コンピュータや機械が視覚的な情報を取得、解釈、理解するための技術や方法論の総称です。CVは、デジタル画像やビデオから特徴を抽出し、それらを解析・処理して高レベルの理解や意味の把握を試みることを目指しています。

CVの主なタスクや技術には以下のようなものがあります。

- 物体検出(Object Detection): 画像やビデオの中から特定の物体や領域を検出するタスクです。物体の位置や境界を特定するだけでなく、複数の物体を同時に検出することも行います。

- 物体認識(Object Recognition): 画像やビデオ内の物体を特定のクラスやカテゴリに分類するタスクです。事前に学習されたモデルやアルゴリズムを使用して、物体の特徴を認識し、それに基づいて分類や識別を行います。

- 姿勢推定(Pose Estimation): 人間や物体の姿勢や位置を推定するタスクです。画像やビデオ内の人物や物体の関節や位置を推定することで、その動作や姿勢を分析することが可能となります。

- セグメンテーション(Segmentation): 画像やビデオ内の特定の領域や物体をピクセル単位で分割するタスクです。各ピクセルに対して、そのピクセルが属するクラスやカテゴリを予測します。

- 特徴抽出(Feature Extraction): 画像やビデオから重要な特徴を抽出するタスクです。これにより、画像やビデオの情報をよりコンパクトに表現することができます。代表的な手法としては、畳み込みニューラルネットワーク(CNN)があります。

- 画像生成(Image Generation): 与えられた条件や要素から新しい画像を生成するタスクです。GAN(Generative Adversarial Network)やVAE(Variational Autoencoder)などの手法が使用され、写真のスタイル変換や画像の合成などが行われます。

コンピュータビジョンは、画像処理、機械学習、ディープラーニングなどの技術や手法を組み合わせて実現されます。CVの応用範囲は広く、自動運転、監視カメラシステム、医療診断、ロボティクス、拡張現実(AR)など、さまざまな領域で利用されています。